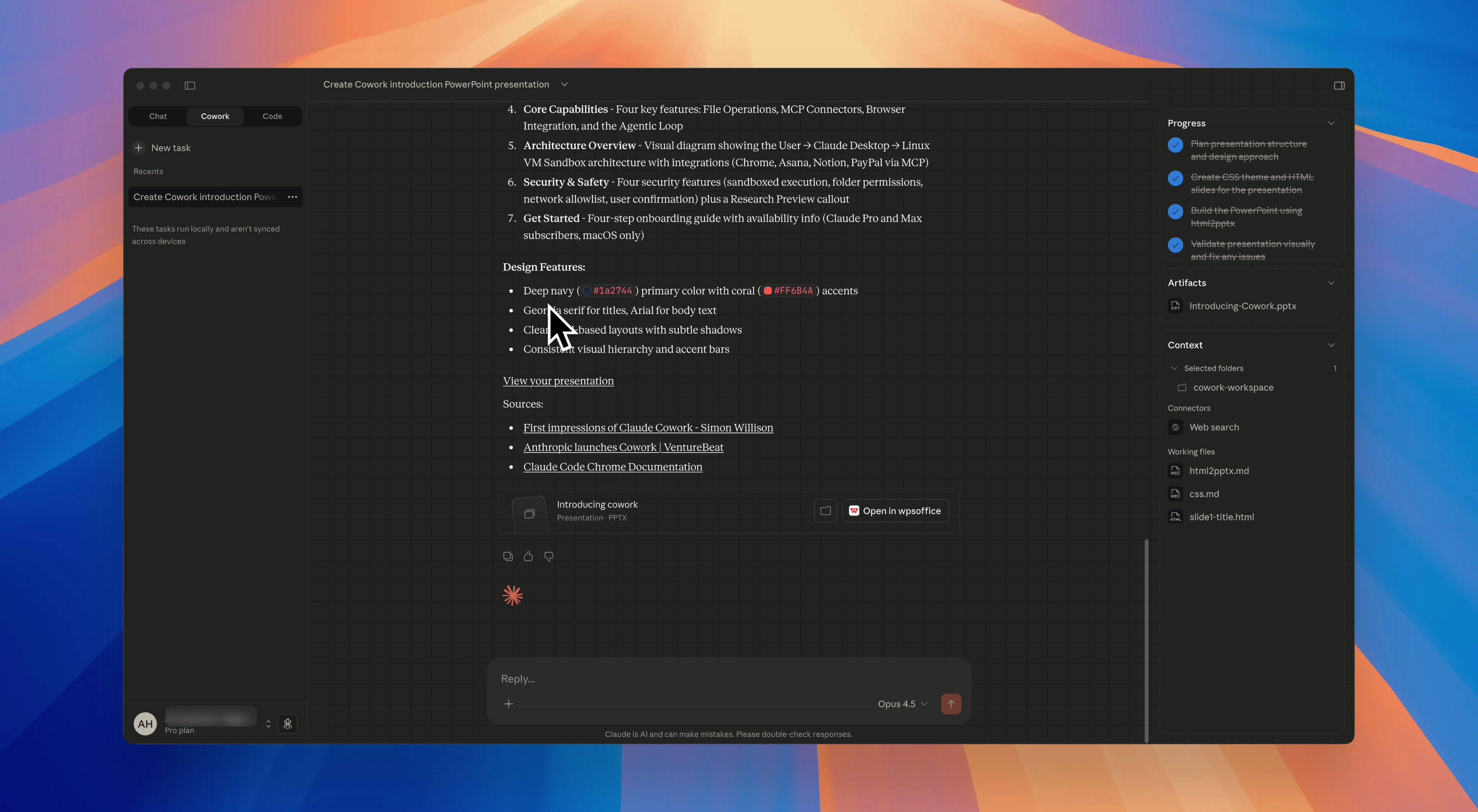

Claude Cowork 的发布不仅仅是另一个 AI 工具的诞生 —— 它标志着向 AI 协作民主化 的根本转变。在这篇文章中,我们将探讨"开放协作"的概念,以及它如何重塑 AI 驱动生产力的未来。

开放协作的理念

"开放协作"(Open Cowork)代表了一种范式,其中 AI 协作工具应该是:

- 可访问的 —— 每个人都能使用,无论技术背景

- 透明的 —— 操作和数据处理方式清晰可见

- 可互操作的 —— 与现有工作流和工具无缝集成

- 可定制的 —— 满足个人和团队的特定需求

Claude Cowork 体现了其中许多原则,将强大的 AI 能力带给非开发者。但开放协作的真正愿景超越了任何单一产品 —— 它是关于构建一个 开放生态系统,让 AI 助手能够无缝融入我们的工作方式。

从 Claude Code 到开放替代方案

演进历程

这段旅程始于 Claude Code,一款面向开发者的终端工具。它被刻意设计为:

"底层且不固执己见,提供接近原始模型的访问,而不强制特定工作流。"

这种理念创造了一个 灵活、可定制、可脚本化且安全的强大工具,深受开发者喜爱。现在,通过 Cowork,这种能力扩展到了每个人。

开源运动

Claude Code 的成功引发了一场 开源革命。开发者们希望获得类似的能力,同时避免供应商锁定或订阅费用。这催生了几个杰出的项目:

| 工具 | Star 数 | 描述 | 最适合 |

|---|---|---|---|

| OpenCode | 60,000+ | 与供应商无关的 Claude Code 替代品 | 自托管灵活性 |

| Cline | 400万+ 安装 | 用于 IDE 的自主 AI 编程智能体 | VS Code/JetBrains 用户 |

| Aider | 25,000+ | Git 感知的终端配对程序员 | 终端优先的开发者 |

| Goose CLI | 15,000+ | 完全本地的 AI 助手 | 离线/隐私优先 |

| OpenHands | 50,000+ | 自主开发智能体 | 复杂多步骤任务 |

深入了解:OpenCode - 开放替代方案

OpenCode 作为 Claude Code 最直接的开源等效品,值得特别关注。

主要优势

1. 供应商无关

支持 75+ AI 提供商:

- OpenAI (GPT-4, o1)

- Anthropic (Claude)

- Google (Gemini)

- 本地模型 (Ollama, LM Studio)

- 开源模型 (Llama, Qwen, GLM)2. 成本效益

| 提供商 | 每百万 Token 成本 | 相比 Claude 节省 |

|---|---|---|

| Claude Sonnet 4.5 | $3-15 | 基准 |

| GLM-4.7 | $0.088 | 97% |

| Qwen-Max | $0.40 | 87% |

| Devstral 2 | $1.20 | 60% |

3. 先进架构

OpenCode 使用客户端/服务器设计,支持:

- 持久的远程 Docker 工作区

- 协作编辑会话

- 自定义工具集成

- 离线部署

性能对比

在相同任务的正面对决测试中:

| 任务 | Claude Code | OpenCode |

|---|---|---|

| 跨文件重构 | 3 分钟 | 3 分钟 |

| Bug 修复 | 40 秒 | 40 秒 |

| 测试生成 | 73 个测试 | 94 个测试 |

| 总时间 | 9分9秒 | 16分20秒 |

结论:Claude Code 优先考虑速度;OpenCode 强调彻底性和灵活性。

构建你的开放协作技术栈

方案 1:纯开源

追求最大控制和零供应商锁定:

技术栈组件:

├── AI 提供商:Ollama + Llama 3.2

├── 编程智能体:OpenCode 或 Cline

├── 文件管理:自定义脚本

├── 集成:开源 MCP

└── 成本:$0(仅计算资源)优点:完全控制、隐私、无经常性费用 缺点:需要技术设置,可能缺少某些功能

方案 2:混合方案

平衡成本、能力和便利性:

技术栈组件:

├── AI 提供商:OpenRouter(多模型)

├── 编程智能体:Cline(VS Code)

├── 通用任务:Claude Cowork(需要时)

├── 集成:开源和商业混合

└── 成本:约 $20-50/月优点:灵活性,不同任务使用最佳工具 缺点:需要管理多个工具

方案 3:企业级开放协作

对于需要治理和规模的团队:

技术栈组件:

├── AI 提供商:Azure OpenAI 或 AWS Bedrock

├── 编程智能体:OpenHands(自托管)

├── 编排:自定义工作流

├── 安全:企业级控制

└── 成本:按使用量 + 基础设施优点:安全、合规、可扩展 缺点:实施复杂

MCP 革命:真正的开放性

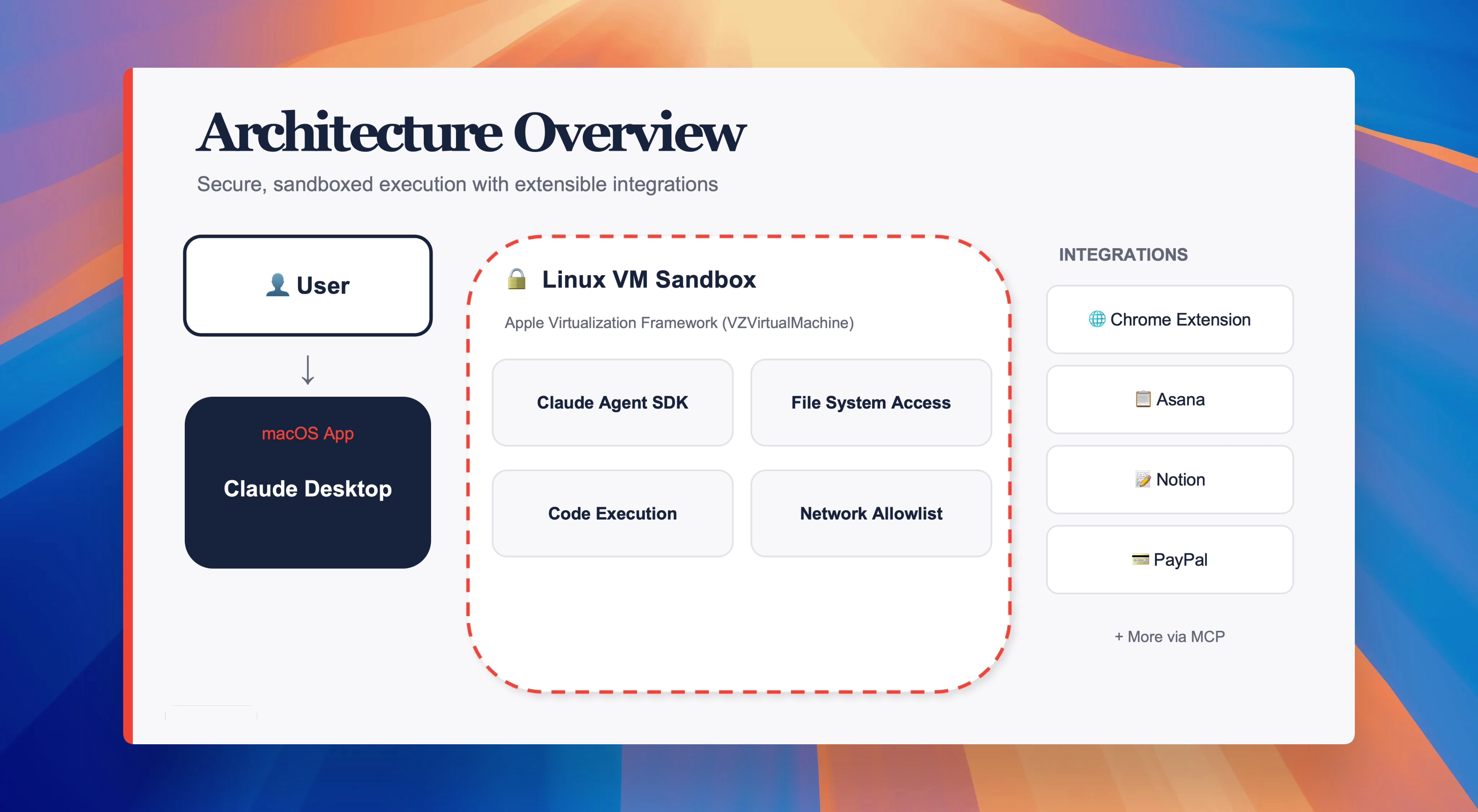

开放协作运动中最重要的发展之一是 模型上下文协议(MCP)。

什么是 MCP?

MCP 是连接 AI 工具与外部服务的标准:

AI 智能体 ←→ MCP 协议 ←→ 外部服务

示例:

- Claude ←→ MCP ←→ Google Drive

- OpenCode ←→ MCP ←→ GitHub

- Cline ←→ MCP ←→ 数据库MCP 为什么重要

- 互操作性:任何兼容 MCP 的工具都可以使用任何兼容 MCP 的服务

- 可扩展性:开发者可以为任何服务创建自定义 MCP

- 可移植性:在 AI 工具之间切换而不丢失集成

流行的 MCP

| MCP | 功能 | 兼容性 |

|---|---|---|

| filesystem | 本地文件访问 | 所有主要智能体 |

| github | 仓库管理 | Claude Code, OpenCode |

| slack | 团队沟通 | Cowork, Cline |

| browser | 网页导航 | Claude, OpenHands |

| database | SQL/NoSQL 访问 | OpenCode, Aider |

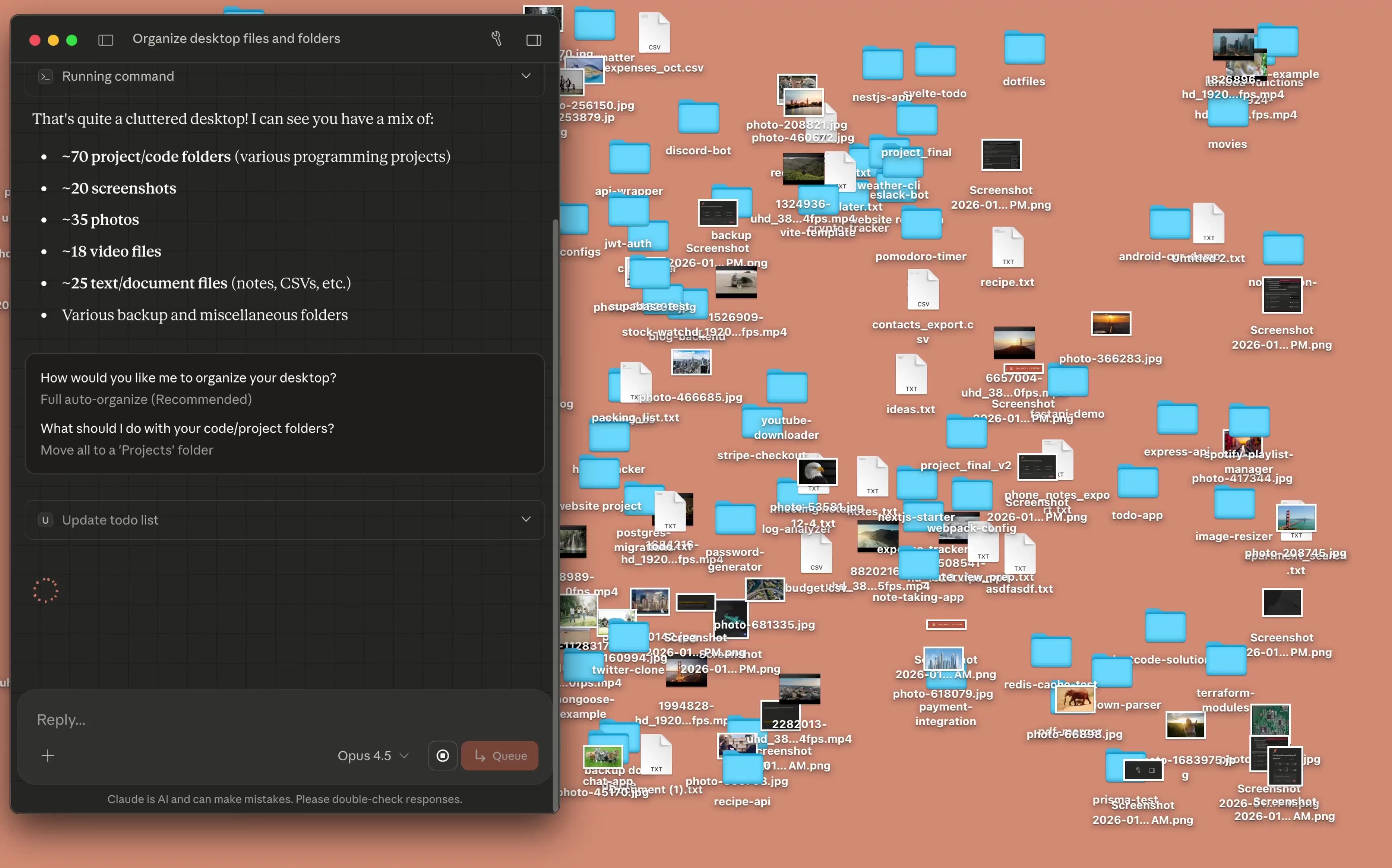

创建你自己的开放协作环境

第一步:选择你的 AI 后端

预算优先的用户:

- 本地:Ollama + Codestral

- API:带成本限制的 OpenRouter

质量优先的用户:

- 带自定义工具的 Claude API

- 特定任务使用 GPT-4o

隐私优先的用户:

- 完全本地运行 Llama 3.2

- 离线部署

第二步:设置你的智能体

终端用户:

# 安装 OpenCode

npm install -g opencode

# 配置提供商

opencode config set provider ollama

opencode config set model codestral:latest

# 开始工作

opencode "重构认证模块"IDE 用户:

- 安装 Cline 扩展

- 配置你首选的 AI 提供商

- 启用 MCP 集成

- 开始 AI 辅助编程

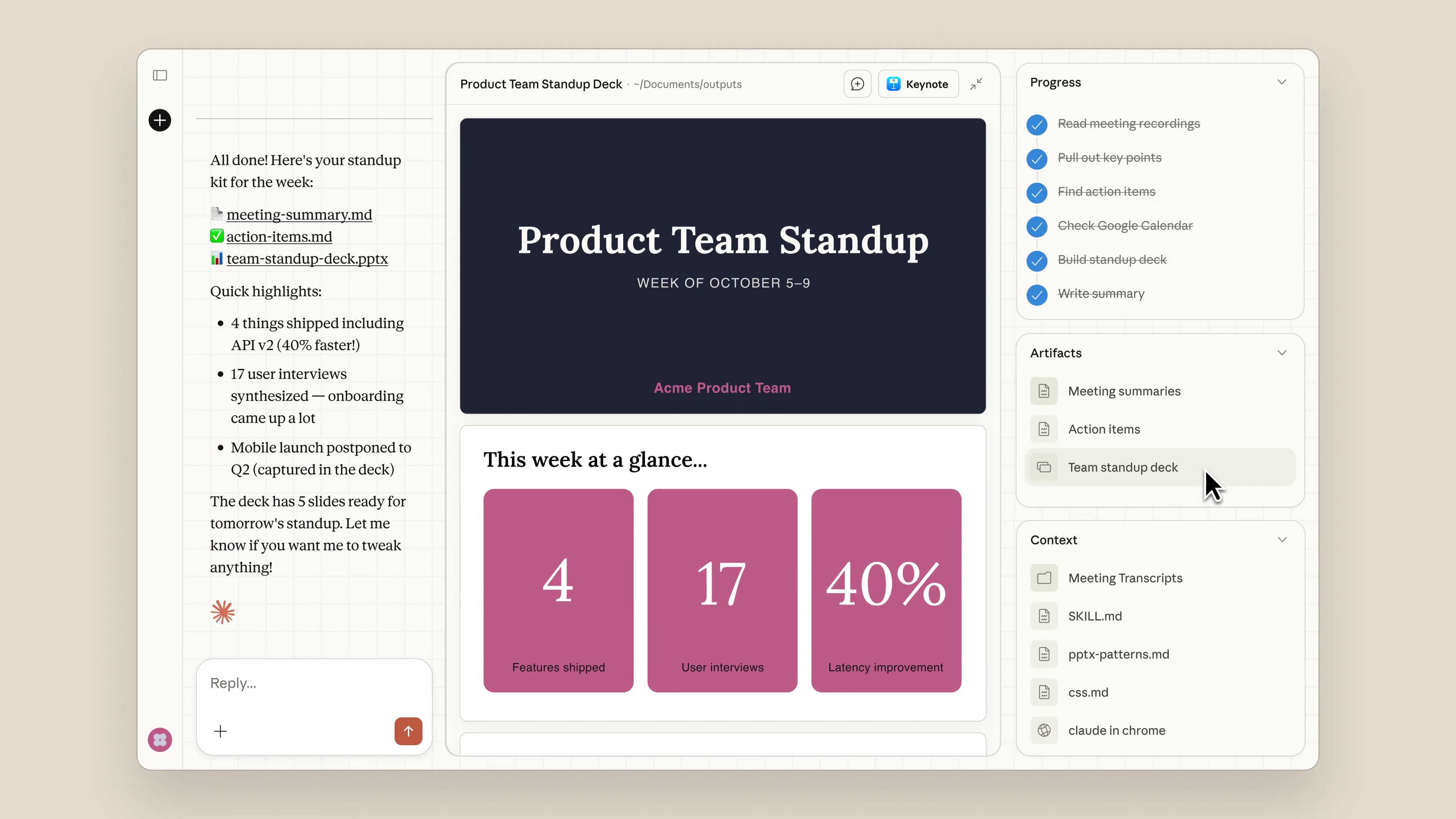

第三步:集成到你的工作流

创建结合多种工具的自定义工作流:

# workflow.yaml

name: "周报生成"

steps:

- agent: opencode

task: "分析过去一周的 git 提交"

- agent: cowork

task: "研究竞争对手更新"

- action: combine

output: "weekly-report.md"开放协作的未来

新兴趋势

1. 多智能体协作 AI 智能体协同工作,每个专注于不同任务:

- 研究智能体收集信息

- 分析智能体处理数据

- 写作智能体创建报告

- 审查智能体检查质量

2. 个人 AI 工作空间 属于你自己的 AI 环境:

- 随时间学习你的偏好

- 跨会话保持上下文

- 与你所有的工具集成

- 本地运行保护隐私

3. 联邦 AI 网络 分布式 AI 系统:

- 模型运行在多个节点

- 没有单点故障

- 通过加密保护隐私

- 用户共担成本

这对你意味着什么

开放协作运动给你 选择:

- 使用 Claude Cowork 获得无缝、精致的体验

- 使用开源替代品 获得控制权和成本节省

- 混合搭配 工具以获得最佳结果

- 在开放基础上构建自定义解决方案

采取行动

个人用户

- 从 Claude Cowork 开始 理解这个范式

- 尝试 OpenCode 或 Cline 处理技术任务

- 探索 MCP 集成 扩展能力

- 加入社区 学习和贡献

团队

- 评估安全要求 以选择 AI 工具

- 试点多种工具 找到最佳匹配

- 制定内部指南 用于 AI 协作

- 培训团队成员 有效使用 AI

开发者

- 贡献开源项目 如 OpenCode 或 Cline

- 构建 MCP 用于你使用的服务

- 分享工作流 让他人可以采用

- 记录最佳实践 回馈社区

结论

Claude Cowork 不仅仅是一个产品 —— 它是向 开放协作 更大运动的一部分,在这里 AI 协作工具是可访问的、透明的、可互操作的。无论你选择 Anthropic 的精致解决方案还是深入充满活力的开源生态系统,目标都是一样的:让 AI 成为每个人真正的同事。

工作的未来不是用 AI 取代人类 —— 而是人类和 AI 开放有效地协同工作。这就是开放协作的承诺。

参考来源: